Ollama について

Ollama とは

Ollama は、ローカル環境で大規模言語モデル (LLM) を簡単に実行できるオープンソースのツールです。インターネット接続不要で AI モデルを動かすことができ、プライバシーを保ちながら AI を活用できます。

公式サイト: https://ollama.com/

Ollama の特徴

- ローカル実行 : インターネット接続不要で AI モデルを実行

- 簡単なセットアップ : コマンド一つでモデルをダウンロード・実行

- 多様なモデル : さまざまな用途に対応した豊富なモデル群

- API サポート : REST API を通じてアプリケーションと統合可能

Ollama ドキュメント

Ollama の公式ドキュメントには、詳しい使い方やカスタマイズ方法が記載されています。

公式ドキュメント: https://docs.ollama.com/

ドキュメントのおもな内容

- Getting Started : Ollama の基本的な使い方

- Model Library : 利用可能なモデルの一覧と説明

- Modelfile : カスタムモデルの作成方法

- API Reference : API の詳細な仕様

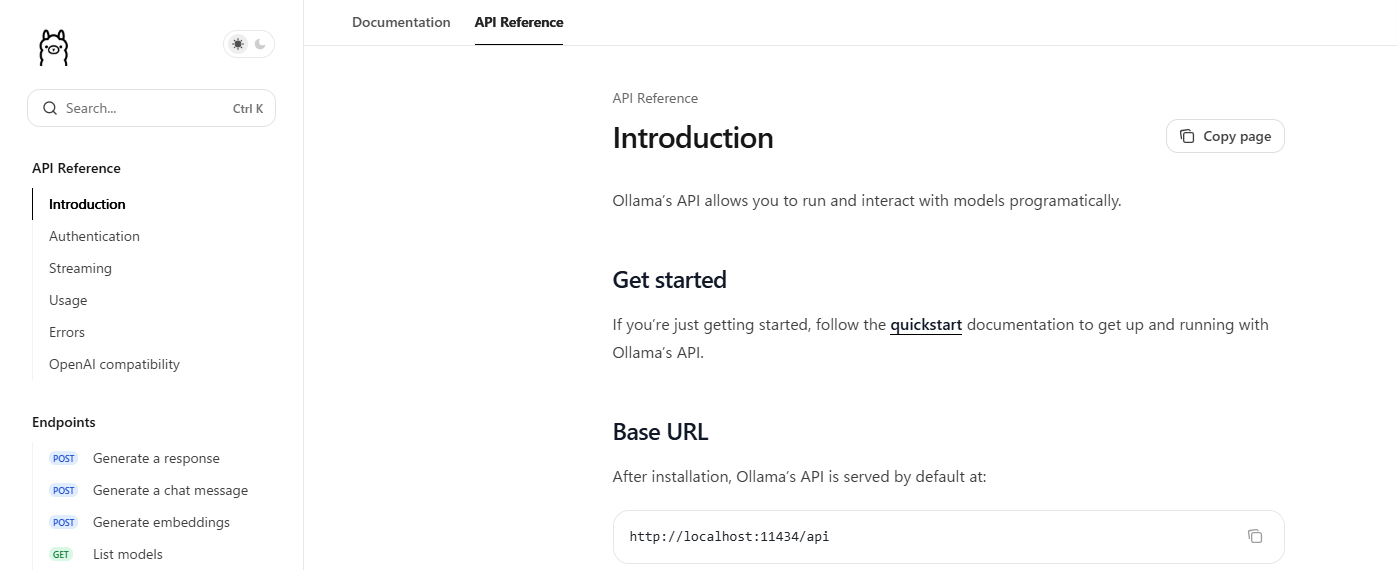

Ollama API について

Ollama は REST API を提供しており、さまざまなプログラミング言語から利用できます。Unity からも HTTP リクエストを通じて Ollama と連携できます。

API ドキュメント: https://docs.ollama.com/api/introduction

API のおもな機能

- Generate : テキスト生成

- Chat : チャット形式での対話

- Embeddings : テキストの埋め込みベクトル生成

- Model Management : モデルの一覧取得・削除

API の使用例

curl http://localhost:11434/api/generate -d '{

"model": "granite3.2:2b",

"prompt": "こんにちは"

}'

Unity から HTTP リクエストを送ることで、同様に Ollama の AI モデルと対話できます。

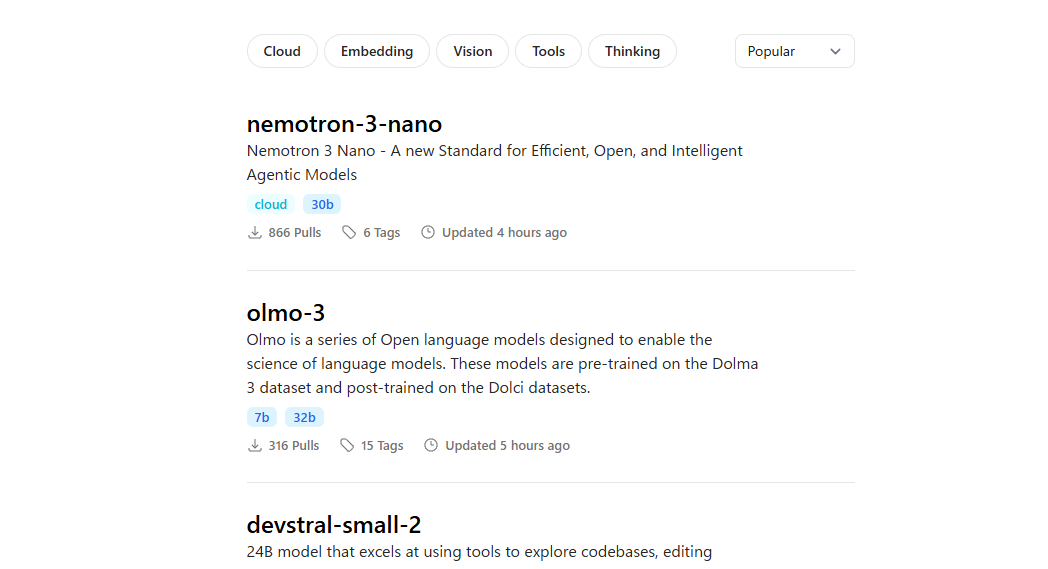

多彩なモデル

Ollama では、さまざまな目的に応じた多数のモデルが提供されています。

モデル検索: https://ollama.com/search

おもなモデルカテゴリー

- 汎用チャット : Llama、Mistral、Gemma など

- コード生成 : CodeLlama、Qwen Coder など

- 軽量モデル : Phi、Granite など(今回使用する granite3.2:2b もこのカテゴリー)

- 日本語対応 : ELYZA、calm など

モデルの選び方

- サイズ : モデルのパラメータ数(2b、7b、13b など)。小さいほど軽量だが性能は控えめ

- 用途 : チャット、コード生成、翻訳など、目的に応じて選択

- 言語 : 日本語対応の有無

本授業では、軽量で動作が速い granite3.2:2b を使用します。

動いているかチェック

API を利用してブラウザから URL にアクセスする形で、ちゃんとインストールが済んでいるか確かめてみましょう。